Manipulacja dowodem społecznym

Tworzenie sztucznych lub selektywnie wzmacnianych sygnałów — polubień, obserwacji, recenzji lub komentarzy — w celu wywołania pozorów popularności, wiarygodności lub rozpędu.

Przegląd

Manipulacja dowodem społecznym tworzy iluzję popularności, zaufania lub rozpędu. Gdy ludzie widzą produkt, usługę lub ideę, która otrzymuje widoczne poparcie — polubienia, obserwacje, recenzje, komentarze — zakładają, że jest ona autentycznie ceniona.

Zniekształcanie dowodu społecznego przybiera trzy główne formy:

- Inżynieria psychologiczna w „legalnym” marketingu — Wykorzystywanie prawdziwych narzędzi dowodu społecznego (referencje, recenzje, odznaki zaufania) często przesuwane w szarą strefę: filtrowanie recenzji, wybiórcze cytaty, fałszywa ograniczoność.

- Manipulacja botami — Fałszywe lajki, obserwacje, komentarze generowane przez farmy botów, click farmy lub skrypty automatyzujące.

- Algorytmiczne sterowanie przez platformy — Wzmacnianie lub wyciszanie treści na podstawie sygnałów interakcji — bez konieczności użycia botów.

Psychologiczne mechanizmy za manipulacją dowodem społecznym

Manipulacja nie tylko tworzy fałszywą popularność — wykorzystuje wbudowane błędy poznawcze, by zmusić ludzi do działania bez oporu:

- Efekt podobieństwa — Bardziej ufamy ludziom podobnym do nas. Fałszywe recenzje i interakcje imitujące „podobnych do nas” zwiększają wiarygodność.

- Konformizm — Dążymy do dostosowania się do grupy. Fałszywe zaangażowanie tworzy normy społeczne, które popychają innych do działania.

- Oszczędność poznawcza — Ludzie szukają skrótów myślowych. Popularność („100k polubień nie może się mylić”) zastępuje analizę.

- Efekt owczego pędu — Ludzie kopiują większość. Wczesne fałszywe zaangażowanie wyzwala kaskady realnych reakcji.

- Autorytet — Interakcje od kont z dużą liczbą obserwujących są uznawane za bardziej wiarygodne.

- Zachowanie stadne — Naśladowanie tłumu postrzegane jest jako bezpieczne — nawet jeśli tłum jest sztucznie wygenerowany.

Kiedy dowód społeczny jest manipulowany na dużą skalę, granica między prawdziwą popularnością a zaprojektowaną widocznością znika. Firmy podejmują decyzje na podstawie zniekształconych danych. Opinia publiczna ulega wpływowi. Reklamodawcy tracą budżety przez click fraud. Procesy demokratyczne stają się podatne na operacje wpływu.

Taktyki

"Legalne" techniki w marketingu

Manipulacja dowodem społecznym jest powszechna w reklamie.

Na stronach i w reklamach:

- Dowód liczbowy: „Dołącz do 10 000 firm, które zwiększyły konwersję o 27%.”

- Oceny sprzedawcy: 5 gwiazdek w rozszerzeniach reklam.

- Autorytet branżowy: „Zaufany przez 65% biur księgowych w UK.”

Hierarchia dowodu społecznego na stronie docelowej:

- Podstawowy: Logotypy klientów, statystyki użycia.

- Wtórny: Imienne referencje, oceny gwiazdkowe.

- Trzeci: Pełne studia przypadków.

Inne triki psychologiczne:

- Odznaki zaufania, powiadomienia w czasie rzeczywistym („Jan z Warszawy właśnie kupił”), wzmianki medialne.

- Celowe rozmieszczenie treści (referencje obok formularzy, statystyki powyżej linii zgięcia).

- Podobieństwo demograficzne w testimonialach.

Nadużycia:

- Review gating: Proszenie o recenzje tylko zadowolonych klientów.

- Wybiórcze referencje: Pokazywanie tylko top 1% opinii.

- Fałszywa ograniczoność: „Zostały tylko 3 sztuki!” mimo pełnych magazynów.

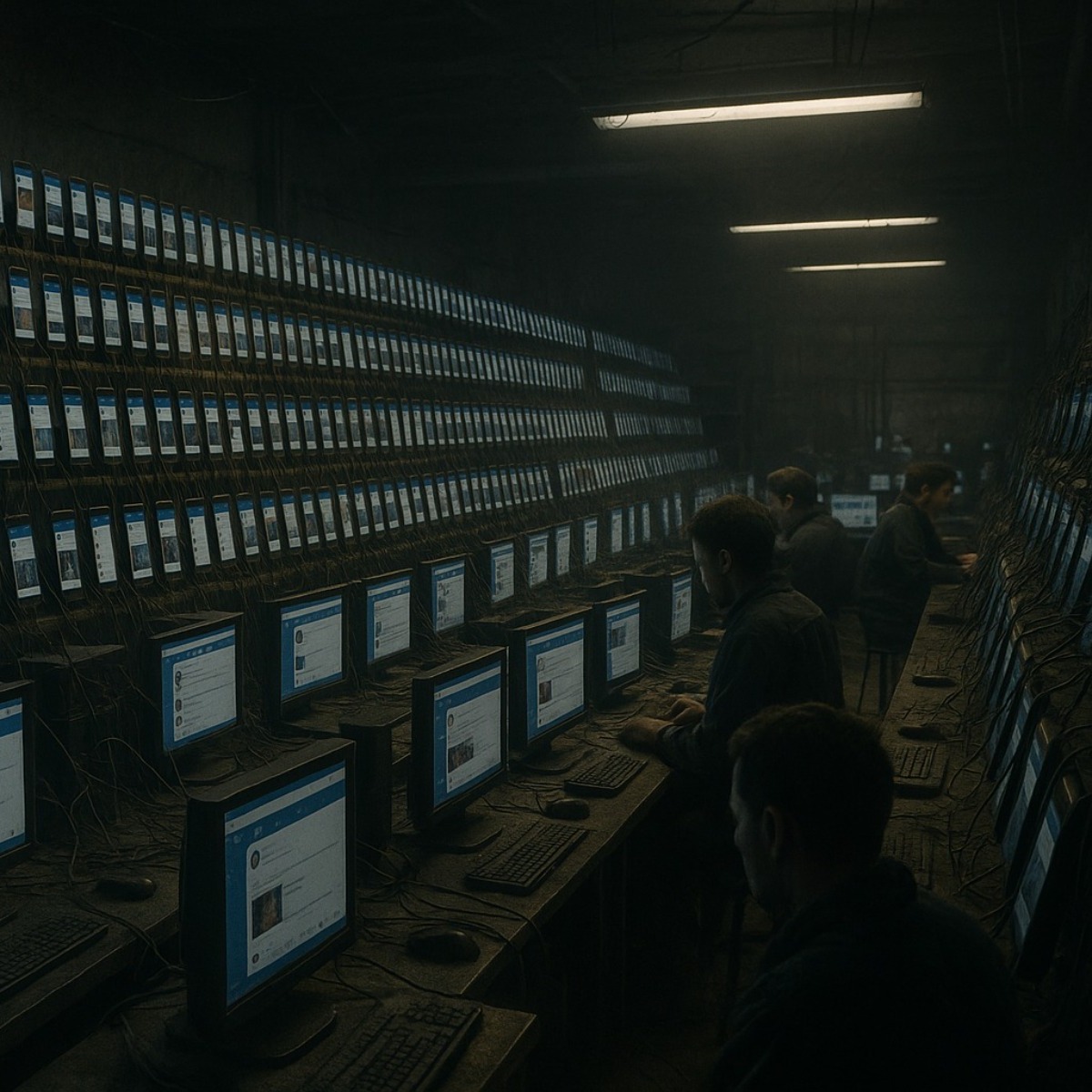

Bot-driven social proof

Sztuczny dowód społeczny tworzony przez ludzi, automaty lub hybrydowe systemy symulujące popularność i wiarygodność.

Źródła manipulacji:

- Click farmy — Ludzie z rynków niskokosztowych ręcznie lajkują, komentują, subskrybują.

- Bot farmy — Automaty imitujące ludzkie zachowania za pomocą narzędzi jak Selenium, Puppeteer, Playwright.

- Marketplace’y — Szare platformy (np. na Telegramie) sprzedające pakiety zaangażowania, często mieszające boty z ludźmi.

Popularne metody:

- Recenzje, komentarze i konta generowane przez AI (modele GPT).

- Wbudowane emocjonalne triggery (strach, euforia) podnoszące skuteczność.

Eksploity algorytmiczne:

- Drip feeding: Stopniowe dodawanie fałszywego zaangażowania (np. 30 lajków dziennie).

- Early spike: Bomba zaangażowania zaraz po publikacji — by manipulować algorytmem platformy.

- Randomizacja działań, rotacja proxy, emulacja urządzeń, konta aged.

Platform-driven social proof

Gdy sama platforma decyduje o widoczności — nie przez oszustwo, ale przez algorytmiczną inżynierię:

- Treści są wzmacniane lub wyciszane w zależności od tego, kto się z nimi kontaktuje.

- Algorytmy symulują popularność przez ranking feedu, depriorytetyzację, efekty wyciszania.

Studium przypadku: Wyprodukowany konsensus na x.com (2025)

Techniczne źródła:

- CSA, Rosyjska propaganda i system Meliorator — analiza systemu do wpływu psychologicznego.

- Sam Sundar, Automatyzacja Twitter(X) w Pythonie

- Muhammad Nazam, Automaty botów na Instagramie krok po kroku

Aspekty prawne i zgodność

Fałszywe zaangażowanie często łamie prawo. W USA i UE manipulacja recenzjami lub poparciem może naruszać prawo konsumenckie, regulacje reklamowe i zasady platform.

Marki muszą dbać o autentyczność, by uniknąć kar: banów, grzywien, pozwów od konkurencji.

Dalsza lektura

- NATO StratCom COE, Manipulacja w mediach społecznościowych — raport z 2024

- Interpol, Beyond illusion

- Clemson University, Botnet polityczny na X

- ScienceDirect, Analiza usług fałszywego zaangażowania

- arXiv, Bot detection: przegląd literatury

- arXiv, Sleeper bots — nowe zagrożenie polityczne

- Sean Park i in., Dowód społeczny w e-commerce