Monday, May 5, 2025

Twój umysł na sprzedaż — jak firmy AI zamieniają Twoje prompt’y w wyzwalacze zakupowe

Posted by

Nowe produkty AI pojawiają się szybciej, niż regulatorzy zdążą mrugnąć

Za błyszczącym marketingiem i hypem innowacyjności wyłania się cichszy wzorzec: systematyczne przechwytywanie prywatnych rozmów, preferencji i psychologicznych odcisków palca — normalizowanych, anonimizowanych i karmionych z powrotem do systemu.

♜ Zbieranie logów czatów to domyślne ustawienie u większości dużych firm AI, zazwyczaj tłumaczone jako "poprawa jakości usług" lub "cele badawcze". OpenAI na przykład w swojej polityce prywatności zastrzega sobie prawo do używania zanonimizowanych danych w celu "analizy sposobu korzystania z usług, ich ulepszania oraz prowadzenia badań".

| Firma | Prawo do użycia promptów? | Retencja danych | Opcja rezygnacji/kontroli | Przegląd przez ludzi | Ocena prywatności |

|---|---|---|---|---|---|

| ChatGPT (OpenAI) | ✅ Tak (domyślnie) | Przechowywane do momentu rezygnacji | Możliwość rezygnacji i żądania usunięcia danych | ❓ Niejasne (monitorowanie bezpieczeństwa) | Umiarkowana |

| Anthropic (Claude) | ⚠️ Tak (tylko po zgodzie) | Dane nieużywane bez feedbacku | Użytkownik może usunąć dane i wyrazić zgodę | ❌ Nie (chyba że oflagowane) | Dobra |

| Google DeepMind (Gemini) | ✅ Tak (domyślnie) | Luka pozwala przetrzymywać do 3 lat | Można wyłączyć aktywność, ale dane są przechowywane | ✅ Tak (agresywnie) | Słaba |

| xAI (Grok) | ✅ Tak (domyślnie) | 30 dni (chyba że powód prawny) | Można usunąć dane w ciągu 30 dni | ❓ Niejasne | Niejasna |

| DeepSeek | ✅ Tak (domyślnie) | Dla zgodności z prawem | Można usunąć historię czatów w każdej chwili | ❓ Niejasne | Słaba |

Uwaga: Linki do polityk prywatności znajdują się w przypisach na końcu.

Warto zaznaczyć, że powyższe regulacje dotyczą tylko aplikacji czatowych dla użytkowników końcowych. W przypadku użycia API, takie dane zazwyczaj nie są zbierane, by nie zniechęcać firm do integracji.

Wzorce obserwowane u "wielkiej piątki" można śmiało ekstrapolować na dziesiątki tysięcy startupów AI walczących o rynek. Ogromne ilości fascynujących danych są zbierane przy minimalnej kontroli regulacyjnej.

To otwiera puszkę Pandory z ryzykiem dla prywatności — i nikt nie jest na to naprawdę gotowy.

Poza jurysdykcją

Nawet Europa, z najmocniejszymi przepisami (GDPR / DPA), jest w tej walce bezsilna. Najlepiej pokazuje to spór między europejskimi regulatorami danych a DeepSeek — chińską firmą oferującą chatbota podobnego do ChatGPT.

Polityka prywatności DeepSeek przyznaje, że firma zbiera logi czatów, ale podkreśla, że nie prowadzi profilowania — co brzmi obiecująco.

Jednak podobnie jak u innych, ich zapisy są otwarte na interpretację:

- dzielenie się danymi z dostawcami zewnętrznymi,

- dzielenie się w ramach grupy kapitałowej,

- przekazywanie danych w razie sprzedaży aktywów.

I oczywiście, DeepSeek podlega chińskiemu prawu, które przez część państw zachodnich jest traktowane jako wrogie.

Ogólnie — Twoje dane są bezpieczne... dopóki nie opłaca się ich sprzedać.

W lutym, po tym jak odkryto publicznie dostępny zbiór danych DeepSeek zawierający logi czatów i dane osobowe, europejskie agencje zażądały dowodów zgodności z GDPR. Odpowiedź DeepSeek była krótka:

Tylko Włochy wprowadziły pełny zakaz, tworząc precedens. Inne kraje wydały ostrzeżenia publiczne — które niczego nie wymusiły.

Naruszenie danych Muah.ai

Muah.ai to platforma, na której użytkownicy tworzą i rozmawiają z "AI partnerami": opiekunkami, wspierającymi chłopakami, wirtualnymi terapeutami.

Jako młoda firma AI, ich regulaminy warto czytać uważnie.

Ich polityka prywatności nie wspomina o zasadach ochrony danych i opisuje firmę wyłącznie jako "procesora danych". Twierdzą, że są "usługą przetwarzania AI", działającą na danych podanych przez użytkownika. (Ale zgodnie z GDPR, jeśli zbierają np. dane konta i historię rozmów — to są też "administratorem danych.")

W zakresie bezpieczeństwa zapewniają, że ich środki są "rozsądne".

Brak jasnych polityk przyniósł przewidywalne skutki: w październiku 2024 doszło do włamania, które ujawniło dane 1,9 mln użytkowników — w tym treści rozmów oraz e-maile.

Okazało się, że jednak byli administratorem danych.

Konsekwencje

Wycieki danych to już fakt i będą się powtarzać — bo wiele firm poświęca bezpieczeństwo, by nadgonić konkurencję.

Zagrożenia można podzielić na dwie główne grupy:

- Przestępcy wykorzystujący luki bezpieczeństwa do wykradania prywatnych rozmów, a potem szantażu lub sprzedaży na czarnym rynku.

- Wrogie państwa używające przejętych danych i historii czatów do precyzyjnych kampanii dezinformacyjnych lub werbowania ludzi pod szantażem.

Choć szantaż i szpiegostwo to poważne zagrożenia, istnieje bardziej subtelne ryzyko.

Niewidoczne żniwo: AI, psychografia i cicha kradzież tożsamości

Wyobraź sobie świat, w którym każdy konsumencki wybór i preferencja są mapowane z ogromną dokładnością — dzięki AI i analizie jakościowej. To nie futurystyczna wizja — to rzeczywistość psychografii AI.

Źródło: insight7.io

Psychografia tradycyjnie opierała się na ankietach — ograniczonych, deklaratywnych i często niewiarygodnych. Teraz mamy coś innego: modele liczące miliardy parametrów, które potrafią automatycznie wzbogacać dane konsumenckie o profile psychograficzne — biernie, masowo, bez zgody.

Zgodnie z przepisami jak GDPR (UE), DPA (UK) czy CCPA (Kalifornia), analiza cech psychologicznych z danych użytkownika powinna być ściśle regulowana.

Ale egzekwowanie przepisów jest nierówne. Poza Kalifornią USA ma luki w ochronie prywatności.

W praktyce wiele firm działa w szarej strefie: korzysta z domniemanej zgody, luk anonimizacyjnych lub tworzy profile psychograficzne poza legalną definicją "danych osobowych". Tak czy inaczej, Twoje dane trafiają do gigantów AdTech.

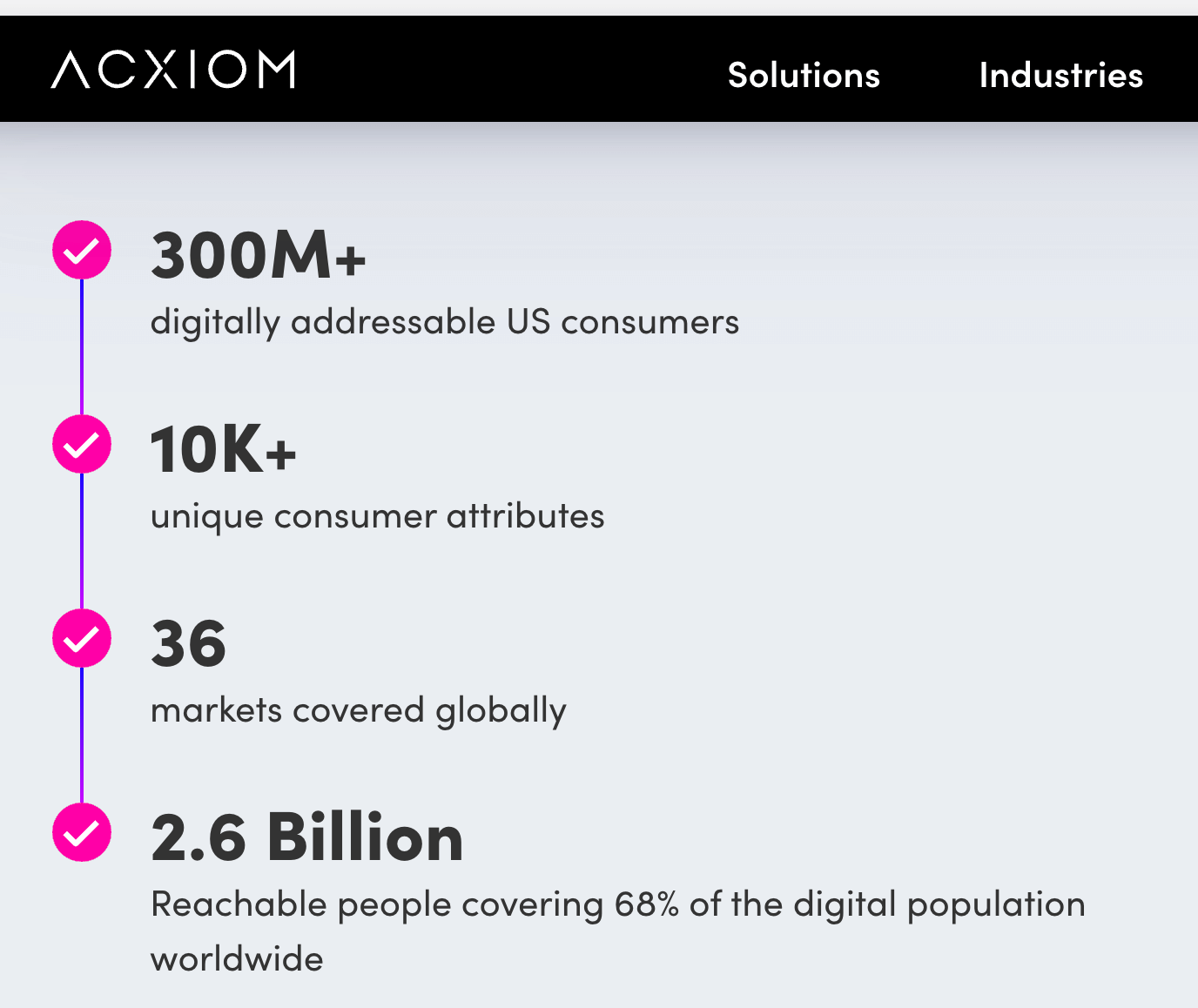

Źródło: acxiom.com

Źródło: acxiom.com

Połowa światowej populacji — i prawie cała populacja USA — "wyraziła zgodę" na przekazanie szczegółowej mapy swojego życia.

Zgodnie z GDPR, CCPA i CPRA, wzbogacanie danych osobowych o cechy behawioralne i psychograficzne wymaga zgody użytkownika lub mocnego interesu prawnego.

Niewiele firm ma lepszą pozycję niż Google, by wykorzystać te luki.

Dzięki danym z wyszukiwarki, YouTube, Androida i teraz Gemini, Google traktuje dane jako surowiec — ekstrahowany, segmentowany i używany do personalizacji na masową skalę.

Google już był karany za naruszenia prywatności. Ich działania AI można postrzegać jako kolejny etap personalizacji reklam.

Google zbiera Twoje rozmowy (w tym nagrania z Gemini Live), pliki, obrazy, ekrany, informacje o używaniu produktów, feedback i lokalizację. Informacja o lokalizacji pochodzi z urządzenia, adresu IP, danych konta Google. Szczegóły: g.co/privacypolicy/location.

Google używa tych danych zgodnie z Polityką Prywatności, by rozwijać usługi i technologie uczenia maszynowego.

Aby poprawić jakość usług, rozmowy z Gemini Apps mogą być przeglądane i analizowane przez ludzi (w tym firmy zewnętrzne).

Źródło: Google Gemini: jakie dane są zbierane i jak są używane

Gdzie Google prowadzi, tam pójdzie cały sektor AdTech.

Na koniec

Od czasu Cambridge Analytica nie było poważnego buntu wobec nadużywania danych. Skandal pokazał, że masowa manipulacja danymi psychologicznymi ma realne konsekwencje.

AdTech się dostosował — i zniknął z radaru.

Może czas na kolejny bunt.

Nie tylko hałas — ale konkret.

Prawna linia wyryta w kamieniu — i zero litości dla tych, którzy ją przekroczą.

♜ Na rook2root.co ujawniamy taktyki, o których nikt nie mówi. Nie po to, by moralizować — tylko by pokazać grę.

♜ Dopiero zaczynamy. Twoje wsparcie teraz znaczy wszystko. Kliknij subskrybuj albo udostępnij ten tekst na X — każdy gest ma znaczenie.

Dalsza lektura

-

wiz.io, Wiz Research ujawnia niezabezpieczoną bazę danych DeepSeek zawierającą dane wrażliwe, w tym historię czatów (styczeń 2025) –

Zespół Wiz odkrył otwartą bazę ClickHouse, zawierającą ponad milion wrażliwych wpisów — w tym historię czatów, klucze API i dane backendowe — bez żadnego uwierzytelnienia. -

usercentrics.com, Regulatorzy UE badają DeepSeek pod kątem naruszeń prywatności (luty 2025) –

DeepSeek mierzy się z rosnącą presją ze strony europejskich organów ochrony danych za gromadzenie i przetwarzanie danych osobowych mieszkańców UE bez zgodności z GDPR. -

Reuters, Włoski regulator blokuje chińską aplikację AI DeepSeek ze względu na ochronę danych (luty 2025)

-

linklaters.com, Wyciek danych muah.ai – szantaż i cyberluki (październik 2024) –

Szczegóły naruszenia bezpieczeństwa w muah.ai — wyciek objął 1,9 mln użytkowników, w tym prywatne wiadomości i adresy e-mail, a także treści o charakterze nielegalnym. -

google.com, Polityka prywatności Gemini Apps — Jakie dane są zbierane i jak są używane (marzec 2025)

-

acxiom.com, Dlaczego marki powinny dbać o lojalność klientów w okresach życiowych zmian (kwiecień 2024) –

Acxiom podkreśla, że marki powinny personalizować interakcje z klientami na podstawie aktualnych danych, szczególnie w momentach przełomowych jak ślub, dziecko, przeprowadzka, by zminimalizować churn. -

acxiom.com, Przyszłość marketingu personalizowanego (październik 2024) –

Segmentacja psychograficzna, demograficzna i behawioralna jako fundament skutecznego marketingu opartego na danych i AI. -

CNBC, Co wiedzą o Tobie brokerzy danych i jak odzyskać kontrolę (październik 2024) –

Brokerzy danych zbierają i sprzedają dane osobowe bez wiedzy użytkownika, często do celów reklamowych i finansowych. -

shyama.com, Cambridge Analytica: Jak profilowanie psychograficzne przekształciło kampanie polityczne (listopad 2024) –

Skandal Cambridge Analytica ujawnił skalę manipulacji cyfrowej demokracji i zapoczątkował debatę nad etyką wykorzystania danych.

Polityki prywatności

- anthropic.com

- x.ai

- openai.com

- deepseek.com

- centrum prywatności Gemini

- google.com — polityka prywatności

Na koniec, dla refleksji

- Vienna Teng, The Hymn of Acxiom

...Ktoś zbiera każdy okruch, który zostawiasz –

(nieświadome decyzje i) chwile, o których już dawno zapomniałeś...